近日,浪潮信息入选北京市通用人工智能产业创新伙伴, “源”大模型将持续加速开放赋能,促进通用人工智能产业发展,提升产业普惠价值。

【资料图】

【资料图】

作为最早布局大模型的企业之一,浪潮信息在业界率先推出了中文AI巨量模型“源1.0”,参数规模高达2457亿。“源1.0”在语言智能方面表现优异,获得中文语言理解评测基准CLUE榜单的零样本学习(zero-shot)和小样本学习(few-shot)两类总榜冠军。 浪潮信息通过千亿参数规模的大模型创新实践,已在算力集群构建、算力调度部署、算法模型开发等方面,构建起全栈领先的大模型算力系统解决方案,助力大模型训练开发。

在算力集群构建上,基于大模型实测对比的集群规划,提供包含数据中心、算力、网络、存储一体化产品阵列。其中最新一代融合架构的AI训练服务器 NF5688G7采用Hopper架构的GPU,较上代平台大模型实测性能提升近7倍,同时支持最新的液冷解决方案,可实现更低的集群能耗比与运行成本,PUE小于1.15,以一个4000卡的智算中心为例,每年可节电620万度、降碳1700吨。在集群高速互联层面,基于原生RDMA实现整个集群的全线速组网,并对网络拓扑进行优化,可以有效消除混合计算的计算瓶颈,确保集群在大模型训练时始终处于最佳状态。

在算力调度部署上,面对大模型系统级开发过程中所存在的调度难、部署慢、效率低、集群异常等问题,浪潮信息推出AIStation智能业务创新生产平台,通过全生命周期的一体化监控及调度系统,构建起完备的模型训练失效恢复持续方案,满足大模型分布式训练中高稳定、高稳健性等特性要求,实现训练异常和故障诊断的自动处理,缩短断点续训时间90%。同时,自研分布式任务自适应系统,有效分配底层计算、存储、网络等资源,提升集群利用率与模型训练效率。高效的集群优化调度策略,大幅简化大模型训练前大量的、环境配置、依赖库适配和超参数调整工作。

在算法模型开发上,“源1.0”针对大模型的Attention层和前馈层的模型空间进行结构优化,改进注意力机制聚焦文章内部联系的学习。千亿大模型的创新实践,使得浪潮信息具备从数据、训练、部署到应用落地的全栈开发能力。在训练数据处理上,通过自研海量数据过滤系统(MDFS),建立从数据采集、粗滤、质量分类、精滤的全自动化的端到端数据工作流程,通过清洗866TB海量数据,获得5TB高质量中文数据集。

在助力大模型训练开发方面,浪潮信息推出AI算力服务,提供经“源”清洗验证过的语言或多模态的大模型数据、算法产品及模型训练资源管理平台,为AI创新研究团队提供先进、开放、高性能、高质量的AI算力资源及配套服务,赋能AIGC创新发展。目前,浪潮信息AI算力服务已成功助力网易伏羲中文预训练大模型“玉言”登顶中文语言理解权威测评基准CLUE分类任务榜单,并在多项任务上超过人类水平。

浪潮信息AI团队将“源1.0”成功的系统工程经验应用于智算中心算力系统,对集群架构、高速互联、算力调度等进行全面优化,对分布式训练策略进行了针对性优化,通过合理设计张量并行、流水并行和数据并行,精准调整模型结构和训练过程的超参数,最终实现千亿参数规模的大模型训练算力效率达至53.5%。

目前,浪潮信息“源1.0”已在众多行业领域实现应用的快速落地,真正实现AIGC的产业普惠:通过构建强大稳健的基础大模型,让千行百业拥有“顺势而为”的大模型能力。浪潮信息推出的“源1.0”开源开放计划,开放模型API、工具链、数据集,构建“开放、共赢”的开发者社区生态,助力开发者快速创新,目前“源开发者社区”已汇聚了近万名高水平开发者,孵化出众多创新应用。

在智能客服领域,通过将“源”大模型的智能力与复杂的服务场景进行深度融合,打造专家级数据中心智能客服大脑,凭借强大的学习能力,“源晓服”能够对知识库进行自主化学习,可覆盖终端用户92%的咨询问题,将复杂技术咨询的业务处理时长降低65%,整体服务效率达160%,荣获评哈佛商业评论鼎革奖。

在智慧政务领域,基于源大模型打造的AI社区助理“临小助“,可为基层社区工作者提供沉浸式、针对性的一对一群众工作能力培训, 社区工作者通过手机载体与“临小助”进行互动对话形式,让社区小白“秒变”服务群众的能人。目前,“临小助”已投入使用,在某高频场景中, 社区工作人员培训学习效率提升5倍, 有效辅助问答建议达至75%。

在智慧文创领域,开发者开发出首个AI剧本杀;基于“源1.0”,开发并上线一个会“闹情绪”的AI陪练,帮助心理咨询师更专业及时地提供各种服务和治疗方案。除此之外,“AI数字人鲁迅”、数字演员、陪伴机器人、游戏NPC对话等极具创新的应用也在不断地孵化落地。

“源1.0”作为新型的大模型算法基础设施,正通过强大的通用智能和全栈的工具链服务能力,助力千行百业开发运行更多的智能应用。

检察官担任法治副校长有了“指挥棒”

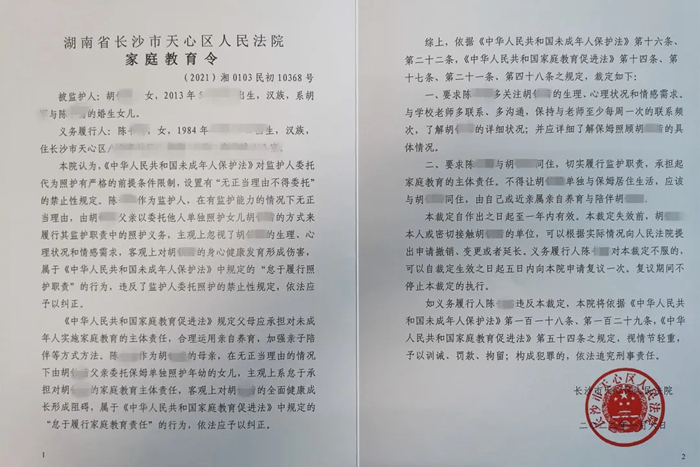

检察官担任法治副校长有了“指挥棒” 全国首份《家庭教育令》来了!督促家长“依法带娃”

全国首份《家庭教育令》来了!督促家长“依法带娃” 俄军装甲车辆将具备隐身能力

俄军装甲车辆将具备隐身能力